- Как провести проверку индексации сайта

- Google пока не заметил ваш веб-ресурс

- Google Search Console

- Закрытые сайт или страницы в robots.txt

- Включены конфиденциальные настройки

- Проблемы при сканировании

- Сайт ограничен в .htaccess

- Нестабильная работа хостинга или сервера

- Проблемы с AJAX/JavaScript

- Дублированный контент

- Медленная скорость загрузки сайта

- Ваш домен ранее был заблокирован

- Отсутствие sitemap на сайте

При занятии продвижением бизнеса в онлайне, неотъемлемой частью работы становится мониторинг индексации страниц вашего сайта. На первый взгляд может возникнуть несколько вопросов: "Зачем это нужно?" (ответ: чтобы ваш сайт был обнаружен пользователями в поисковой выдаче), "Где можно проверить индексацию сайта?" и "Как поступить, если сайт не проиндексирован?".

Разберемся с этими вопросами в данном материале.

Как провести проверку индексации сайта

Прежде чем приступить к продвижению сайта, важно оценить его видимость в популярных поисковых системах. Оценить видимость можно, например, с помощью специализированных инструментов, таких как Serpstat.

Для оценки видимости сайта достаточно ввести домен в поисковую строку и выполнить поиск. Однако этот показатель относителен и требует сравнения с основными конкурентами.

Если уровень видимости низкий, необходимо проверить индексацию веб-ресурса и добавить информацию о нем в базу данных поисковых систем.

Простейший способ проверить индексацию – воспользоваться вебмастерской панелью. Для этого требуется доступ к ней (через почту Google и регистрацию-идентификацию). При наличии доступа переходим в Панель, выбираем Search Console и переходим к разделу Индекс Google. Здесь можно увидеть статус индексирования.

Индексация сайта – это результат работы поискового бота. Бот сканирует тексты, изображения, видео, а затем добавляет информацию о веб-странице в базу поисковой системы. Этот процесс позволяет пользователям получать актуальные результаты по своему запросу. Информация, собранная ботом, влияет на ранжирование сайтов в поисковой системе.

Возьмем, например, сайт известного Бердичевского пивоваренного завода - https://berdpivo.com.ua/

Теперь рассмотрим подробнее причины, по которым поисковые системы могут не проиндексировать ваш сайт.

Google пока не заметил ваш веб-ресурс

Иногда бывает так, что Google просто не обращает внимание на ваш сайт, особенно если он новый. Это часто происходит из-за того, что молодые сайты попадают в так называемую "Песочницу" – это своего рода временное хранилище для веб-ресурсов, пока поисковая система не разберется, что это за сайт, каков его характер, и кому он предназначен.

Если ваш сайт уже существует более 6 месяцев (максимальное время пребывания в Песочнице), но его "видимость" все еще оставляет желать лучшего, возможно, причиной являются фильтры поисковых систем. Это может быть вызвано неуникальным контентом (скопированным с других источников) или наличием материалов, выходящих за рамки моральных норм, призывающих к насилию или не имеющих подтвержденной экспертизы.

Например, на сайте, посвященном производству пива, отсутствуют имена авторов, рекомендующих данный товар.

Если ваш сайт не является новым, и с контентом все в порядке, теоретически необходимо дать поисковым системам время для его индексации в Google – как минимум 2 недели.

Однако процесс можно ускорить. Для того чтобы поисковики быстрее обратили внимание на ваш сайт, рекомендуется вручную добавить его в поисковую систему (используя "Add URL") и в Google Search Console.

Как добиться индексации сайта в Google?

Для этого важно регулярно обновлять контент (что особенно актуально для новостных сайтов), создавать новые страницы (это важно для блогеров и интернет-магазинов с растущим ассортиментом) и проводить внутреннюю перелинковку страниц, совместно с получением ссылок от авторитетных внешних ресурсов.

Google Search Console

Добавление сайта в Google Search Console (Гугл вебмастер) – это легкий процесс, и вот подробная инструкция:

-

Откройте Google Search Console

Первым шагом является посещение официального сайта Google Search Console (https://search.google.com/search-console/). -

Перейдите в Инструмент проверки URL

Внутри консоли найдите раздел "Инструмент проверки URL" или "URL Inspection Tool" и кликните по нему. -

Вставьте URL сайта

В открывшемся инструменте введите или вставьте URL вашего сайта в строку поиска. -

Ожидайте проверки Google

После ввода URL дождитесь, пока Google проведет проверку указанного адреса. Это может занять некоторое время в зависимости от различных факторов. -

Запросите индексацию: После завершения проверки вы увидите результаты. Если сайт не проиндексирован или вы хотите обновить индексацию, нажмите на кнопку "Запросить индексирование" или "Request Indexing".

Таким образом, вы сообщите Google о необходимости проиндексировать ваш сайт или обновить информацию о нем. Этот процесс помогает ускорить индексацию и сделать ваш сайт доступным в поисковой выдаче Google.

Не забывайте, что для выполнения этих действий вам нужно иметь учетную запись Google и добавить свой сайт в Google Search Console. Если вы этого еще не сделали, вам придется следовать простой процедуре добавления сайта перед выполнением перечисленных выше шагов.

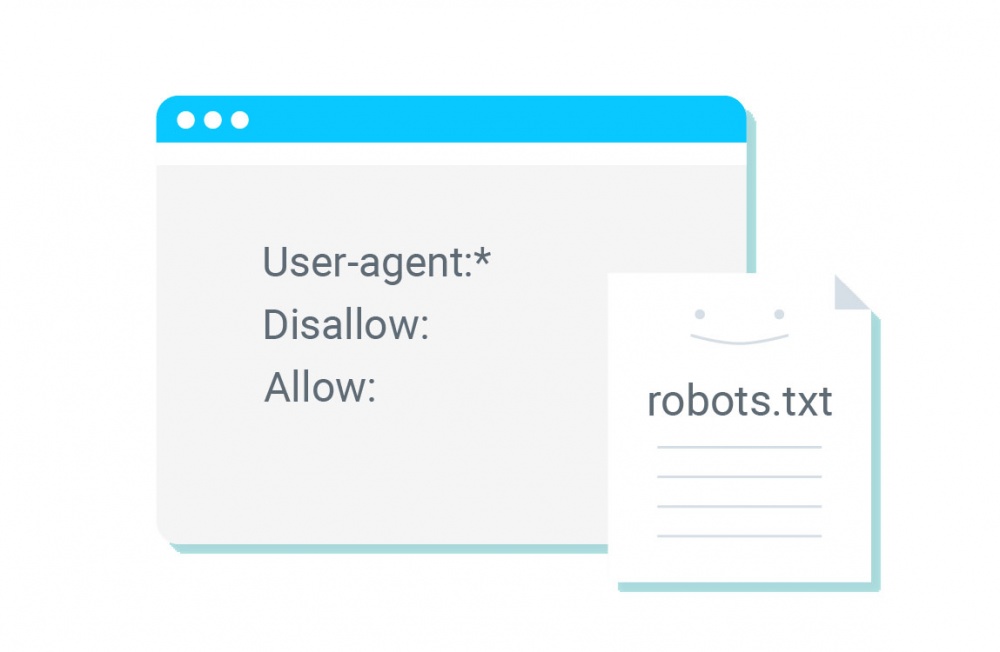

Закрытые сайт или страницы в robots.txt

Файл robots.txt представляет собой мощный инструмент для управления поведением поисковых роботов, в том числе и Google. В этом файле содержатся инструкции, определяющие, какие страницы поисковые роботы могут обрабатывать на вашем сайте. Этот файл позволяет искусственно ограничивать количество запросов на сканирование, что может снизить нагрузку на сервер, особенно для менее важной или повторяющейся информации.

Для того чтобы страница не отображалась в результатах поиска Google, ей можно также добавить директиву noindex.

Пример файла robots.txt для сайта https://berdpivo.com.ua/robots.txt

User-agent: *

Disallow: /закрытая-страница/

Важно отметить, что даже если вы запретите индексацию в robots.txt для определенной веб-страницы, она все равно может быть проиндексирована Googlebot, если на нее есть ссылки с других сайтов. Это применяется только к контенту в формате HTML. Заблокированные файлы в форматах PDF, изображения или видео будут надежно скрыты от Google. Чтобы гарантированно исключить индексацию страницы с контентом в формате HTML в Google, следует использовать директиву noindex в мета-теге или в HTTP-заголовке ответа.

Далее приведены примеры директив в robots.txt, позволяющих роботам Google сканировать веб-ресурс:

User-agent: Googlebot

Disallow:

User-agent: AdsBot-Google

Disallow:

User-agent: Googlebot-Image

Disallow:

Эти строки разрешают роботам Googlebot, AdsBot-Google и Googlebot-Image сканировать веб-ресурс.

Включены конфиденциальные настройки

Иногда поисковый робот Google не индексирует веб-сайт по наивной причине – в системе управления контентом (CMS) активированы конфиденциальные настройки. CMS представляет собой движок веб-сайта, такой как WordPress, Joomla, OpenCart. CMS - это набор скриптов, обеспечивающих создание, редактирование и управление содержимым на сайте. Для обеспечения процесса индексации страницы необходимо проверить параметры страницы в конкретной CMS.

Сайт отмечен как не подлежащий индексации с использованием метатегов noindex

Мета-теги (HTML) необходимы для структурирования содержимого веб-страницы и, как правило, указываются в заголовке HTML-документа. Обязательным элементом является атрибут content, к которому добавляются дополнительные параметры.

Присутствие метатега noindex nofollow указывает, что поисковые боты не должны индексировать данную страницу. Запрет может быть обусловлен временным характером содержимого страницы, предназначением для печати или наличием конфиденциальной информации. Подробные инструкции по закрытию страницы для индексации можно найти на нашем веб-сайте.

Пример использования метатега meta noindex в HTML-документе, который блокирует доступ поискового бота Google:

<meta name="googlebot" content="noindex">

Для предотвращения индексации страницы ботом MSN используем "волшебные слова":

<meta name="msnbot" content="noindex">

Для отмены запрета на индексацию целой страницы удаляем ключевое слово "noindex" из кода.

Наличие метатега robots в коде страницы, сочетаемое с ключевым словом noindex, указывает поисковым роботам на запрет индексации сайта Google.

Пример кода метатега robots с запретом индексации в HTML-документе:

<meta name="robots" content="noindex">

Где искать информацию о метатеге robots noindex? Посетите Google Search Console. Откройте раздел "Индекс", выберите "Покрытие" и перейдите во вкладку "Исключено". Если указано, что индексация страницы запрещена тегом rel noindex, то становится ясной причина закрытия веб-ресурса для индексации. Не забудьте снять запрет, если вы ищете способы проиндексировать страницу в Google.

Проблемы при сканировании

Ошибки при сканировании могут привести к приостановке индексации в Google, снижению рейтинга сайта в поисковой выдаче и воздействию на общее восприятие посетителями веб-ресурса. Специалисты выделяют три основные группы причин ошибок при сканировании:

-

Неправильные настройки сервера.

-

Сбои в системе управления контентом (CMS).

-

Изменения в структуре URL.

Ошибки сканирования могут быть обнаружены с использованием инструментов Google Search Console. Для этого необходимо зайти в раздел статистики сканирования веб-ресурса. Если вы определили конкретную ошибку, рядом с ней должно быть пояснение для веб-мастера, включая причину ее возникновения и методы устранения. Тем не менее, мы также предоставили для вас текст с инструкцией по устранению ошибок при сканировании. Воспользуйтесь им!

Важно! Информация в Search Console поступает с небольшой задержкой, поэтому ошибки могут уже быть устранены, но они могут все еще отображаться в консоли.

Сайт ограничен в .htaccess

Один из способов ограничения доступа к веб-ресурсу заключается в блокировке в файле .htaccess. Это мера принимается с целью предотвратить случайным посетителям доступ к определенным файлам, папкам или административной панели сайта. Владелец не желает устанавливать пароль для этих структурных элементов, но при этом не хочет допускать несанкционированных посетителей. Для этого в папке с конфиденциальной информацией создается файл с именем .htaccess.

Пример кода для запрета доступа к файлу file.php по IP-адресу выглядит следующим образом:

Order Deny,Allow

Deny from all

Allow from Ваш IP адрес

</Files>

После применения этого кода все запросы к указанному файлу с чужого IP будут завершаться ответом 403 "Доступ запрещен". Если владелец ресурса желает ограничить доступ ко всем файлам с определенным расширением, первая строка будет иметь вид:

<Files "*.conf">. Если существует несколько расширений, их можно указать через разделитель, например: Для проверки применения этих ограничений, необходимо найти файл .htaccess на сервере и внимательно изучить его содержимое. Этот вариант следует рассмотреть, когда исследуется причина ограничения доступа сайта для поисковых систем.

Нестабильная работа хостинга или сервера

Если хостинг или сервер испытывают перебои в работе, это может стать причиной неудачной индексации. Представьте себе ситуацию: поисковый бот приходит на сайт, готовый проиндексировать страницы, а ни одной страницы недоступно из-за проблем с хостингом или сервером.

Поэтому задача владельца ресурса состоит в том, чтобы обеспечить высокое качество работы сервера и стабильность хостинга.

Мониторинг состояния доступа к сайту можно осуществлять с использованием различных сервисов. Поиск таких сервисов по запросу "uptime checker" предоставит множество вариантов инструментов, которые помогут отслеживать стабильность работы хостинга.

Проблемы с AJAX/JavaScript

Хотя Google индексирует AJAX и JavaScript, это происходит не так просто, как в случае HTML. Разработчику необходимо настроить процессы индексации AJAX и JavaScript вручную, чтобы обеспечить успешную индексацию сайта и нужных страниц. Для решения проблем с видимостью сайтов на JavaScript-движках можно обратиться к мнению экспертов и использовать соответствующие методы.

Дублированный контент

Присутствие дублированного контента в 2021-2022 годах может стать серьезной причиной санкций поисковых систем. После введения фильтров, особенно алгоритма Панды, важно избегать дублированного контента, чтобы избежать штрафов. Специалисты SEO разработали эффективные методы оптимизации, позволяющие избежать проблем с дублированным контентом, не нарушая при этом оптимизацию.

Дублированный контент может быть как на уровне страниц, так и в метатегах. Для исключения дублированного контента необходимо сначала обнаружить все дубликаты страниц на сайте и затем удалить или закрыть их от индексации.

Медленная скорость загрузки сайта

Низкая скорость загрузки сайта представляет собой один из критически важных факторов в ранжировании поисковых систем и попадании в верхнюю десятку результатов. Этот показатель включает в себя время запроса к стороннему серверу, его ответ, загрузку скриптов, стилей, изображений, а также компиляцию страницы и ее отрисовку на стороне пользователя. Исследования подтверждают, что большинство пользователей теряют интерес, если страница загружается более 3 секунд.

Скорость загрузки сайта непосредственно влияет на конверсию, уменьшает отказы, повышает глубину просмотра страниц, что в конечном итоге способствует росту среднего чека и общей выручки. Если сайт демонстрирует долгую загрузку, поисковики могут также недооценивать его в процессе индексации.

Для улучшения скорости загрузки сайта можно применить следующие меры:

-

Оптимизация изображений

Уменьшение размера изображений, удаление лишних, использование форматов с поддержкой сжатия. -

Сжатие gzip

Компрессия данных перед их передачей клиенту с помощью gzip может значительно сократить объем передаваемой информации. -

Кэширование данных

Использование кэширования для ускорения доступа к ресурсам и снижения нагрузки на сервер. -

Оптимизация кода CSS и JavaScript

Сокращение объема кода и удаление неиспользуемых элементов. -

Исследование скорости загрузки страниц

Проведение анализа скорости загрузки с целью выявления слабых мест и их последующего устранения.

Даже небольшое улучшение времени загрузки, например, на 0,5 секунды, может значительно повысить эффективность сайта в 80% случаев. Дополнительные способы ускорения загрузки верхней части страницы сайта, такие как оптимизация заголовков (header), могут быть изучены в соответствующих руководствах и мануалах.

Ваш домен ранее был заблокирован

Иногда веб-мастер создает отличный сайт, подбирает к нему привлекательный домен, создает стильный дизайн, наполняет его уникальным и экспертным контентом, проводит внутреннюю перелинковку, настраивает систему обратных ссылок, но поисковые системы принципиально не видят этот веб-ресурс. Как обеспечить отображение сайта в поисковике? Причиной этой проблемы может быть использование домена, который ранее был заблокирован.

Чтобы решить этот вопрос, рекомендуется:

-

Продолжать активное развитие проекта.

-

Связаться с Google или обратиться на форум для выяснения причин блокировки и последующего устранения проблемы.

-

Возможно, развивать проект на другом домене, чтобы сэкономить время и ресурсы.

Отсутствие sitemap на сайте

Одной из возможных причин невидимости сайта для поисковых систем может быть отсутствие sitemap (карта сайта) на сайте. Поисковые боты, заходя на сайт, случайным образом индексируют лишь несколько страниц, после чего, удовлетворенные результатами, покидают его. Создание и настройка карты сайта (sitemap.xml) для Google может решить эту проблему. Вот одна из лучших инструкций по созданию и настройке карты сайта для Google, которую можно добавить в Google Search Console.

Пример карты сайта: https://berdpivo.com.ua/sitemap.xml

Полезно! Если нужно, можно посмотреть видеоинструкцию по созданию XML карты сайта.

Создание карты сайта может быть масштабным и важным процессом, особенно для динамических информационных ресурсов. Для новостных блоков часто создают отдельную XML карту сайта, отправляют запрос в Новости Google и добавляют ее в news.google.com, чтобы поисковые роботы могли быстрее находить и индексировать такой контент.

Кроме того, для изображений может быть создана отдельная карта сайта - Image sitemap XML. Это необходимо для обеспечения быстрой и правильной индексации изображений. Мы предоставляем подробный мануал по созданию XML карты сайта для изображений.